고정 헤더 영역

상세 컨텐츠

본문

이번 머신러닝을 진행하면서 깨달은 점이 많다 여러가지를 시도해봤던것같고

처음으로 타겟이 연속형수치형 데이터였다

따라서 리그레션 모델도 처음 써보게되었다

크게 클래스파이와 리그레션으로 나뉜다는 사실도 이번에 하면서 알게되었다

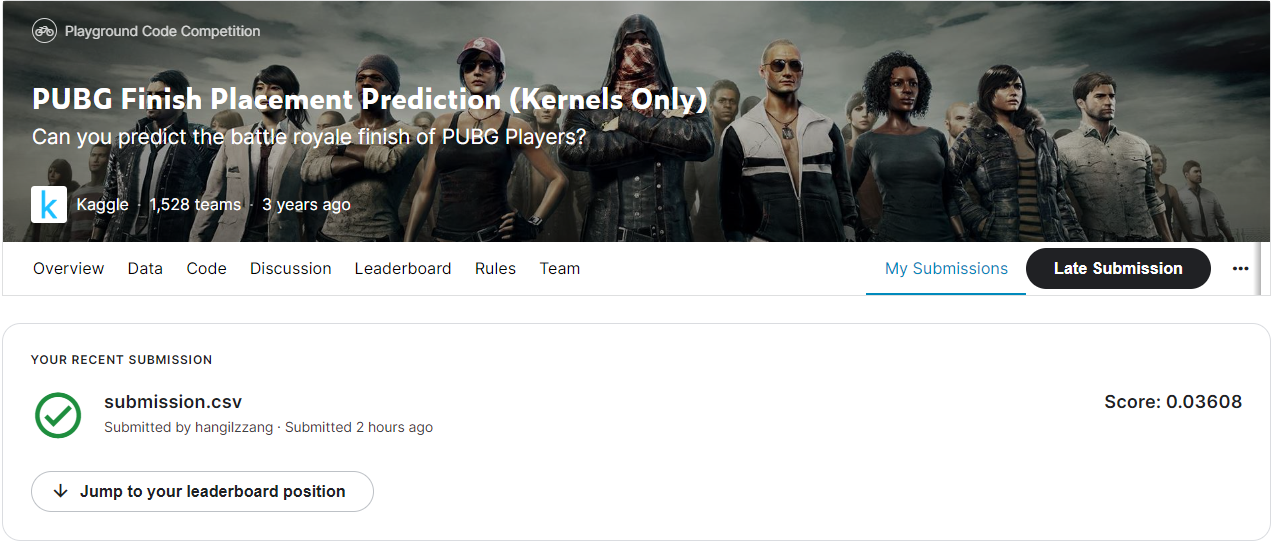

결과부터 말씀드리자면 상위40%를 달성하게되었다 짝짝짜

부족하지만 제가쓴 노트북 링크도 첨부합니다

https://www.kaggle.com/code/hangilzzang/hangilzzang-s-notebook

타이타닉스페이스쉽과, 타이타닉에 이은 나의 3번째 머신러닝 프로젝트이다 처음으로 평균을 넘는데 성공한데 나에게 축하를 보낸다. 뒤에선 내가 이번 프로젝트를 통해 깨달은것들을 한번 나열해보는 시간을 가졌다

1. 현재 가장뛰어난 모델 3대장은 Catboost, XGBoost, LGBM이다

2. LGBM은 속도가 매우빠르다 성능도 catboost보단 밀리지만 그래도 뛰어나다(default기준)

3. XGBoost와 LGBM은 하이퍼 파라미터에 매우 민감하다 Catboost는 디폴트에서도 최적화가 잘되어있음

4. 같은 모델을 계속 돌리는경우(칼럼추가, 전처리 수정등) 정확한 점수 측정을위해 교차검증 이용

5. 스태킹 모델에 소프트백터머신, KNN넣으면 안돌아감 시간 너무오래걸림

6. 그냥 스태킹 자체가 별로같음 디폴트로 넣었더니 Catboost하나 쓴것보다 살짝 떨어지는성능

(거기들어갈 모델정하고, 하이퍼파라미터까지 정해야함 들이는 노력이 큰데 성능이 향상될지도 장담못함)

7. 이상치 데이터가 너무 큰경우 컬럼을 하나더 만들어서 이상치라고 표기하는 방법이 있다

8. 컬럼은 많을수록 좋다

9. LGBM기준으로 feature importance가 너무 낮은 컬럼인경우 삭제했을때 오히려 점수가 올랐다

너무 많은 feature수는 모델을 지나치게 복잡하게 만든다고 한다

10. Catboost는 하이퍼파라미터 튜닝하면 한세월 걸려서 포기했다 어차피 최적화가 잘되어있어서 알고보니 딱히

하이퍼파라미터 튜닝할필요도 없는 나같은 초보자한테는 최고인 모델이었다

11. 하이퍼 파라미터 튜닝할때는 optuna를 이용한다 하이퍼 파라미터 튜닝잘된 LGBM과 Catboost중에 뭐가 더 나은지는 아직 잘 모르겠다 비교를 안해봐서

이번에 머신러닝해보면서 그래도 다양한 기법들을 알게되었고

스태킹, 앙상블, 후처리, 하이퍼파라미터 튜닝등등 모두 한번씩 써봤기때문에 코드를 이해할수있고 형식을 저장할수있었다

대충 머신러닝이 뭔지 감은 잡은것같긴하다 하지만 상위권에 가려면 어떤점을 더 보안해야 했을까 머리가 아파온다...

머신러닝, 처음에 배울때는 재미하나도없었지만 그래도 캐글이라는 시스템덕분에 흥미가 생겼다

더 좋은점수를 얻으려면 어케했었어야 했을까? 어렵당 수고했다 내자신, 다음에 또 재밌게 해보자

'프로그래밍 > 경진대회(데이콘, 캐글)' 카테고리의 다른 글

| kobert를 이용한 영화리뷰 긍정,부정 분류와 대표리뷰 뽑아내기 (0) | 2022.07.21 |

|---|---|

| Digit Recognizer - kaggle 컴퓨터비전 차근차근 이해해보기 (0) | 2022.07.17 |

| flask활용한 머신러닝 모델 웹에 구현하기 (0) | 2022.07.07 |

| 혼자 도전해본 머신러닝(캐글)-타이타닉 우주선 (0) | 2022.06.04 |

| 기쁘다!!! 캐글 리더보드에 이름올리기!(타이타닉) (0) | 2022.05.29 |